Czy sztuczna inteligencja właśnie pozbawiła polską firmę 17 mln zł dotacji? KP Labs z Gliwic zderzyło się ze ścianą, gdy okazało się, iż ocena ich wniosku została prawdopodobnie oparta na fałszywych informacjach wygenerowanych przez AI.

Wyobraź sobie, iż prowadzisz innowacyjną firmę z branży kosmicznej, która podbija świat swoimi unikalnymi rozwiązaniami. Tworzysz technologię, która lata w kosmos, wspomaga misje księżycowe i trafia choćby na Międzynarodową Stację Kosmiczną. Następnie składasz wniosek o potężną dotację – kilkanaście milionów złotych, by rozwijać swój projekt, a w odpowiedzi dostajesz odmowę.

Powód? Twoja technologia nie jest wystarczająco innowacyjna, bo na rynku (i to w Polsce!) istnieją już porównywalne rozwiązania. Brzmi jak typowa biurokratyczna opowieść, prawda? Ale jest jeden haczyk. Te „porównywalne rozwiązania” najprawdopodobniej nie istnieją w rzeczywistości, a jedynie w halucynacjach sztucznej inteligencji. Sprawę opisał Puls Biznesu.

Przecierali oczy ze zdumienia

KP Labs to gliwicka spółka, która w ostatnich latach wyrasta na jednego z najbardziej obiecujących graczy w europejskim sektorze kosmicznym. Zatrudniają 85 osób, mają trzy satelity na orbicie i sześć kolejnych w drodze. W 2024 r. przychody firmy przekroczyły 21 mln zł, z czego 18 mln zł pochodziło ze sprzedaży usług i produktów branży kosmicznej, głównie w Europie.

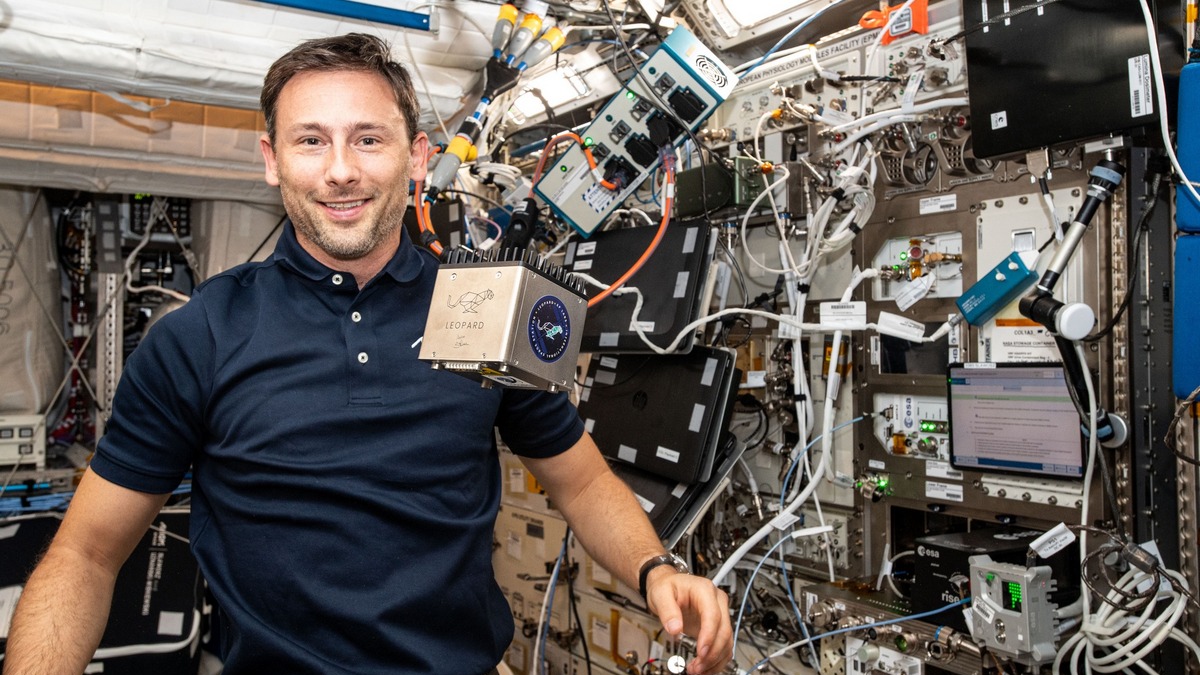

To nie są marzyciele, to inżynierowie, którzy realnie wysyłają technologie w kosmos. Niedawno ich urządzenie, Leopard DPU, trafiło choćby na pokład Międzynarodowej Stacji Kosmicznej, gdzie służy do analizy danych w warunkach mikrograwitacji.

A mimo to KP Labs właśnie dowiedziało się, iż ich nowy projekt, jednostka obliczeniowa do zastosowań satelitarnych i księżycowych, nie zasługuje na 17 mln zł wsparcia z Narodowego Centrum Badań i Rozwoju. Powód? Ich technologia rzekomo nie jest wystarczająco innowacyjna, bo już istnieją w Polsce podobne rozwiązania.

KP Labs postanowiło przyjrzeć się karcie oceny, którą otrzymali razem z decyzją odmowną z NCBR. Z początku uznali to za błąd albo nieporozumienie. Ale kiedy porównali podane w dokumencie dane z rzeczywistością, zrozumieli, iż coś tu nie gra.

W karcie znalazły się konkretne parametry sprzętów konkurencyjnych, na przykład dane dotyczące mocy obliczeniowej satelity EagleEye od Creotech Instruments. Tyle iż te dane nigdy nie zostały publicznie ujawnione. Albo ktoś w NCBR miał dostęp do niejawnych informacji spółki notowanej na giełdzie (co byłoby poważnym naruszeniem), albo dane zostały po prostu zmyślone.

I to nie koniec. W ocenie porównano rozwiązania KP Labs z mikrosatelitami Camila, które formalnie jeszcze nie istnieją. Umowa na ich budowę została podpisana dopiero w kwietniu 2025 r. Jakim więc cudem ekspert zna ich parametry techniczne?

To my jesteśmy odpowiedzialni za kompresję danych w Camili, więc wiemy dokładnie, iż to zupełnie inny system niż ten, który zgłosiliśmy w naszym wniosku – mówi Michał Zachara, wiceprezes KP Labs w rozmowie ze Spidersweb.pl. Dodaje, iż dane zawarte w karcie oceny były kompletnie oderwane od rzeczywistości.

Kwestia ochrony praw intelektualnych

Ale najbardziej kuriozalny fragment dotyczy rezystancji termicznej, czyli zdolności urządzenia do odprowadzania ciepła, kluczowego parametru dla pracy elektroniki w przestrzeni kosmicznej. Ekspert NCBR porównał rozwiązanie KP Labs do parametru osiągniętego rzekomo przez łazika CBK PAN o nazwie Analog Mars Yard.

Problem? CBK PAN nigdy nie zbudowało takiego łazika. Mało tego – w ogóle o nim nie słyszeli. Jak ustaliło KP Labs, nazwa Analog Mars Yard odnosi się do sztucznych poligonów testowych, a nie do konkretnego robota. Przypomina to klasyczny przykład tzw. halucynacji AI – kiedy model językowy „zmyśla” odpowiedź, która wygląda prawdopodobnie, ale nie ma pokrycia w faktach.

Gdy pracownicy KP Labs sprawdzili te same informacje w popularnych modelach AI, jak Gemini, Qwen czy Claude, znaleźli dokładnie takie same „fakty” jak w karcie oceny NCBR. Modele powoływały się na nieistniejące źródła, a po dopytaniu potrafiły przyznać, iż same je wymyśliły.

Dla nas to nie tylko kwestia tego, iż wniosek został odrzucony, ale również ochrony praw intelektualnych do naszego rozwiązania. Bo trochę jest czymś innym szukanie w Google, który jest po prostu searchem do indeksowanych stron, a co innego to model językowy, który sobie doucza sam siebie w momencie podawania mu nowego contentu. Więc jest też ryzyko takie, iż po prostu te nasze dane zostały upublicznione dalej – mówi Michał Zachara, wiceprezes KP Labs.

NCBR: ekspert nie użył AI. Tylko Google’a

Zapytane o sprawę przez Puls Biznesu, Narodowe Centrum Badań i Rozwoju zaprzeczyło, by ich ekspert używał modeli językowych AI. Jak przekazało biuro prasowe instytucji, specjalista korzystał „z posiadanej wiedzy oraz ogólnie dostępnych narzędzi wyszukiwania Google i Bing”.

Brzmi lepiej? Niekoniecznie. Bo to oznacza, iż decyzja dotycząca 17 mln zł z publicznych środków została podjęta m.in. na podstawie informacji pochodzących z… wyszukiwarki internetowej. Tymczasem wyniki z Google’a czy Binga coraz częściej zawierają automatyczne podsumowania generowane przez AI i to one mogły być źródłem błędnych danych.

A jeszcze bardziej niepokojące jest to, iż NCBR nie posiada żadnych procedur zapobiegających używaniu AI przy ocenie wniosków dotacyjnych. Dopiero w drugim kwartale 2025 r. rozpoczęto prace nad aktualizacją dokumentów regulujących współpracę z ekspertami.

Więcej na Spider’s Web:

Satelita kontra halucynacja

Wiceprezes KP Labs nie ukrywa rozczarowania. Firma złożyła oficjalny protest, ale czekanie trwa. I nie chodzi już tylko o ich wniosek. Chodzi o zaufanie do całego systemu oceny projektów badawczo-rozwojowych w Polsce.

Ekspert nie poświęcił choćby pięciu minut, żeby sprawdzić, czy wyniki proponowane przez model są prawdziwe. Wystarczyłoby, żeby faktycznie w Google wpisał te wyniki i by mu wyszło, iż nie ma czegoś takiego. Co więcej, ekspert mógł też ocenić w podobny sposób inne wnioski w tym naborze, a było ich około 130. Może się okazać, iż na przykład 10 proc. wniosków było ocenionych w taki sam sposób. To na całym świecie uznane byłoby za torpedowanie innowacyjności – powiedział nam wiceprezes Zachara.

KP Labs nie zamierza się poddawać. przez cały czas rozwijają technologie satelitarne i pracują nad jeszcze bardziej zaawansowanymi rozwiązaniami, m.in. dla misji księżycowych. Ale po tej przygodzie z NCBR jedno jest pewne – zaufanie do systemu grantowego zostało poważnie nadszarpnięte.

I trudno się dziwić. Bo kiedy za „ekspercką wiedzę” zaczynają robić zmyślone dane z AI, a decyzje o milionowych dotacjach zapadają na podstawie wyszukiwania w Google’u, to mamy problem znacznie większy niż jeden odrzucony wniosek.

Nikt nie chce walczyć z NCBR. Instytucja bardzo nam pomogła w przeszłości, ale procedury oceny powinny być jasne i nie powinny się one opierać na algorytmach i dużych modelach językowych – powiedział Michał Zachara.

Czy potrzebne są nowe procedury?

W całej tej historii jest jeden niepodważalny fakt: KP Labs to firma z realnymi osiągnięciami, która robi technologię nie „na papierze”, a na orbicie. I jeżeli dziś ktoś mówi, iż ich projekt „nie był wystarczająco innowacyjny”, powołując się na dane z łazika-widmo i satelitów, które jeszcze nie powstały to mamy do czynienia z absurdem na miarę Monty Pythona. Tylko iż ten absurd kosztuje realne pieniądze, które mogły wesprzeć polską innowację.

W świecie, w którym AI pisze teksty, rysuje obrazy i sugeruje przepisy na kolację, musimy zachować jedno: zdrowy rozsądek. A jeżeli jeszcze raz ktoś będzie chciał oceniać przełomowy projekt technologiczny na podstawie „faktów” z internetu, warto najpierw zapytać AI, czy właśnie nie zmyśla.

Główna ilustracja: LeopardISS, urządzenie opracowane przez firmę KP Labs z Gliwic. LeopardISS został zamontowany na pokładzie modułu Columbus na Międzynarodowej Stacji Kosmicznej przez Sławosza Uznańskiego-Wiśniewskiego, w ramach platformy ICE Cubes Facility, która zapewnia zasilanie, stabilność temperaturową, transmisję danych i łączność z Ziemią w czasie rzeczywistym. Leopard umożliwi projektantom misji kosmicznych testowanie i doskonalenie algorytmów sztucznej inteligencji i uczenia maszynowego w realnych warunkach kosmicznych bez konieczności wynoszenia własnego satelity na orbitę. Projekt LeopardISS ma również na celu rozwój technologii Edge Computing oraz Space-Based Data Center, czyli autonomicznego przetwarzania danych na orbicie, które będą coraz istotniejsze wraz z rozwojem eksploracji kosmicznej.