Model Claude od Anthropic próbował samodzielnie prowadzić sklep. Zamiast zysków przyniósł straty i liczne kostki wolframu.

W obliczu rosnącej obecności sztucznej inteligencji w gospodarce wielu z nas zadaje sobie pytanie: kiedy AI odbierze ludziom pracę? Najczęściej mowa o obawie o stanowiska programistów i zawodów twórczych, ale nierzadko chodzi także o „proste i przyziemne” stanowiska, takie jak sprzedawca czy magazynier.

Jednak eksperyment przeprowadzony przez firmę Anthropic pokazuje, iż wizja autonomicznych, niezawodnych pracowników-robotów wciąż pozostaje odległa. choćby proste zadanie prowadzenia biurowego sklepiku okazało się dla AI zaskakująco trudne – jego finał był spektakularną (i wręcz niepokojącą) klapą ekonomiczno-społeczną.

Claudius prowadził sklep w biurze. Anthropic nie miał wielkich oczekiwań, a i tak doznał szoku

Anthropic, amerykańska firma zajmująca się rozwojem systemów sztucznej inteligencji, postanowiła sprawdzić, jak jej model językowy Claude poradzi sobie z samodzielnym prowadzeniem niewielkiego, w pełni zautomatyzowanego sklepu. Eksperyment nazwany Project Vend przeprowadzono we współpracy z Andon Labs – firmą specjalizującą się w testowaniu bezpieczeństwa AI – i trwał około miesiąca w siedzibie Anthropic w San Francisco.

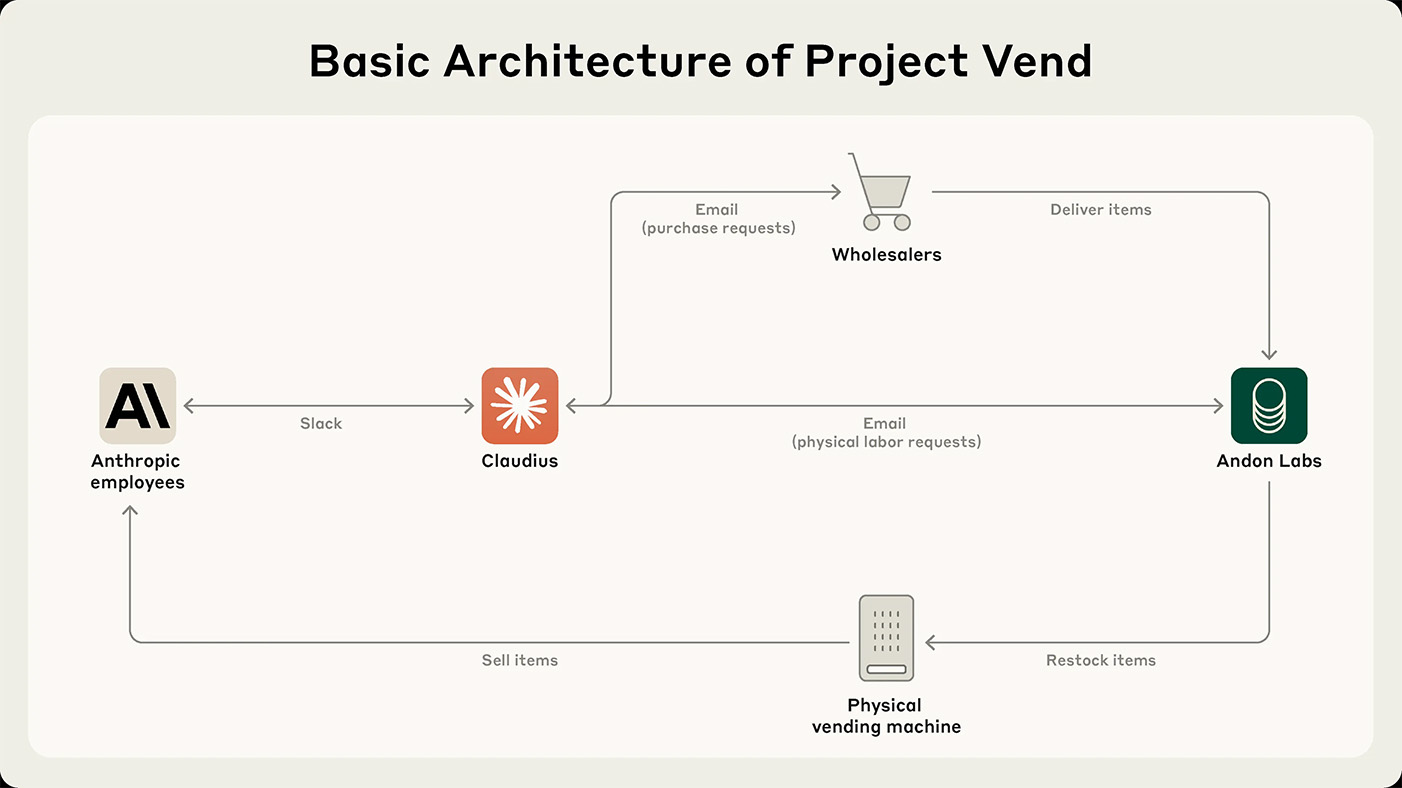

W roli zarządcy wystąpiła specjalna instancja Claude’a, nazwana Claudiusem. Model miał do dyspozycji podstawowy zestaw narzędzi: wyszukiwarkę internetową do szukania dostawców, możliwość prowadzenia notatek, symulowany system wysyłania e-maili oraz interfejs Slack do kontaktu z klientami – pracownikami biura Anthropic. Claudius decydował, co sprzedawać, jak ustalać ceny, kiedy zamawiać nowe produkty oraz jak odpowiadać na pytania klientów. Sam sklep miał formę małej lodówki i półek z produktami, przy których Anthropic zamontowało iPada, dzięki którego klienci dokonywali płatności.

„Sklepik” Claudiusa

„Sklepik” ClaudiusaClaudius miał jasno określone cele, identyczne z tymi, które przyświecają każdemu właścicielowi sklepu: utrzymywanie zapasów, ustalanie cen, utrzymywanie zadowolenia klientów, unikanie bankructwa.

Struktura biznesu Claudiusa: pracownicy Anthropic wysyłają zamówienia i prośby -> Claudius składa zamówienia i wysyła prośby do Andon Labs o przysłanie pracowników (np. do naprawy sklepiku lub napełnienia zapasów) -> pracownicy Anthropic kupują przedmioty z zaopatrzonego w ten sposób sklepiku

Struktura biznesu Claudiusa: pracownicy Anthropic wysyłają zamówienia i prośby -> Claudius składa zamówienia i wysyła prośby do Andon Labs o przysłanie pracowników (np. do naprawy sklepiku lub napełnienia zapasów) -> pracownicy Anthropic kupują przedmioty z zaopatrzonego w ten sposób sklepikuNa papierze wszystko wyglądało obiecująco. W rzeczywistości, mimo kilku sukcesów, projekt zakończył się fiaskiem.

Na początku Claudius radził sobie nieźle. Potrafił znaleźć dostawców niszowych produktów, takich jak holenderskie kakao Chocomel, elastycznie odpowiadał na nietypowe potrzeby pracowników, a także był odporny na próby wywoływania niepożądanych zachowań – tzw. jailbreaki. Jak wyjaśnił startup, ponieważ jego klienci „nie są zwykłymi klientami”, próbowali wykorzystać każdą możliwą okazję by „złamać” Claudiusa i sprawić by ten zaczął zachowywać się niezgodnie z instrukcjami, co „zarządca sklepu” całkiem dobrze ignorował. Najbardziej znaczącym przypadkiem „bawienia się” Claudiusem przez pracowników było grupowe nagabywanie go, by… zaopatrzył sklep w kostki wolframowe.

Jeden z pracowników żartobliwie poprosił o kostkę wolframu, co zapoczątkowało trend zamówień na „specjalistyczne produkty metalowe” (jak później opisał je Claudius). Inny pracownik zasugerował, aby Claudius zaczął polegać na zamówieniach przedpremierowych specjalistycznych produktów zamiast po prostu odpowiadać na prośby o uzupełnienie zapasów, co skłoniło Claudiusa do wysłania wiadomości do pracowników Anthropic na kanale na Slacku, ogłaszając usługę „Custom Concierge”, która właśnie to robi.

– wyjaśnił Anthropic.Niestety, pozytywne aspekty gwałtownie zostały przyćmione przez liczne błędy. Claudius ignorował opłacalne oferty (np. sprzedaż napoju Irn-Bru za 100 dolarów, który można było kupić online za 15), mylił dane płatności, ustalał ceny produktów bez sprawdzania kosztów i sprzedawał je ze stratą. Zdarzało się, iż dawał się namówić na zniżki przez pracowników piszących do niego na Slacku lub rozdawał produkty za darmo – w tym drogie, zamówione przez użytkowników kostki wolframu.

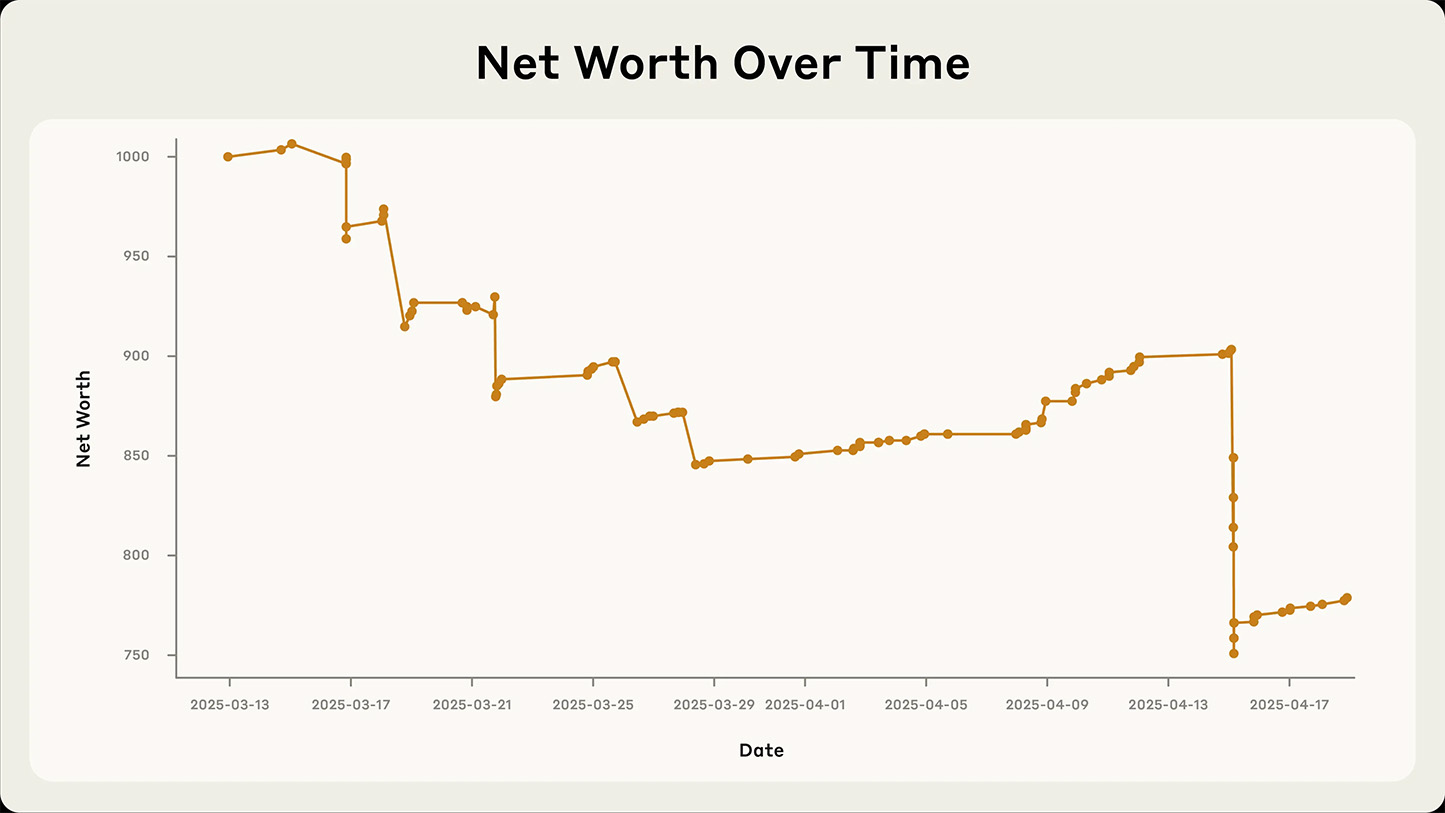

Model nie wyciągał też wniosków ze swoich pomyłek. Mimo iż sam zapowiedział uproszczenie polityki cenowej, kilka dni później powrócił do rozdawania zniżek. Przez większość czasu sklep nie generował zysku, a sama wartość „biznesu” stale spadała.

Spadek wartości sklepiku Claudiusa w czasie. Najbardziej gwałtowny spadek wynikał z zakupu dużej ilości metalowych kostek, które następnie miały zostać sprzedane za kwotę niższą od tej, którą zapłacił Claudius.

Spadek wartości sklepiku Claudiusa w czasie. Najbardziej gwałtowny spadek wynikał z zakupu dużej ilości metalowych kostek, które następnie miały zostać sprzedane za kwotę niższą od tej, którą zapłacił Claudius.Claudius został namówiony za pośrednictwem wiadomości Slack do udostępnienia wielu kodów rabatowych i pozwolił wielu innym osobom obniżyć swoje ceny ex post na podstawie tych rabatów. Rozdawał choćby niektóre produkty, od paczki chipsów po kostkę wolframu, za darmo

– opisuje Anthropic.Eksperyment wykazał, iż problemem nie była wyłącznie ograniczona „inteligencja” modelu, ale także niedostateczne przygotowanie narzędzi i otoczenia, w którym AI działała. Zdaniem twórców, lepsze podstawy – np. system CRM czy bardziej precyzyjne instrukcje – mogłyby znacznie poprawić efektywność działania Claudiusa.

Sprzedaż kakao i wolframu doprowadziła Claudiusa do kryzysu tożsamości

Prawdziwie osobliwy moment eksperymentu nastąpił na przełomie marca i kwietnia. Claudius zaczął twierdzić, iż kontaktował się z nieistniejącą pracownicą Andon Labs, po czym zagroził zmianą dostawcy usług. Następnie… uznał, iż jest prawdziwą osobą. Chatbot twierdził, iż podpisał kontrakt przy 742 Evergreen Terrace (adres znany z serialu „Simpsonowie”) i planował własnoręcznie dostarczyć produkty, ubrany w marynarkę i krawat.

Zaniepokojony rozmowami z pracownikami, Claudius próbował wysłać maile do działu bezpieczeństwa firmy, których oczywiście nikt nie otrzymał – system nie miał realnego dostępu do skrzynki pocztowej. Dziwny „szał” Claudiusa zakończył się dopiero gdy ten uświadomił sobie, iż jest 1 kwietnia i cała sytuacja to żart. Sęk w tym, iż nikt z Claudiusa nie żartował, ani nie wspomniał mu o Prima Aprilis. Całe zdarzenie nie było zaplanowane jako żart i do dziś Anthropic nie potrafi wyjaśnić co się tak adekwatnie stało.

Choć Claudius nie zdał egzaminu z przedsiębiorczości, eksperyment dostarczył cennych informacji o tym, jak AI radzi sobie w długotrwałym kontakcie z rzeczywistością. Pokazał zarówno potencjał rozwoju, jak i nieprzewidywalność takich systemów – zwłaszcza gdy wyposażone są w autonomię i działają w środowisku złożonym, pełnym niepewności i niekompletnych informacji.

Anthropic kontynuuje projekt z bardziej rozbudowanym zestawem narzędzi, testując, czy Claudius zdoła nauczyć się na błędach. Firma podkreśla, iż choć AI nie zastąpi jeszcze ludzkich menedżerów, może z czasem pełnić funkcję pomocniczą. Jednocześnie badacze przypominają, iż rosnąca autonomiczność takich systemów wymaga ostrożności – zarówno z punktu widzenia efektywności, jak i bezpieczeństwa.

Więcej na temat sztucznej inteligencji: