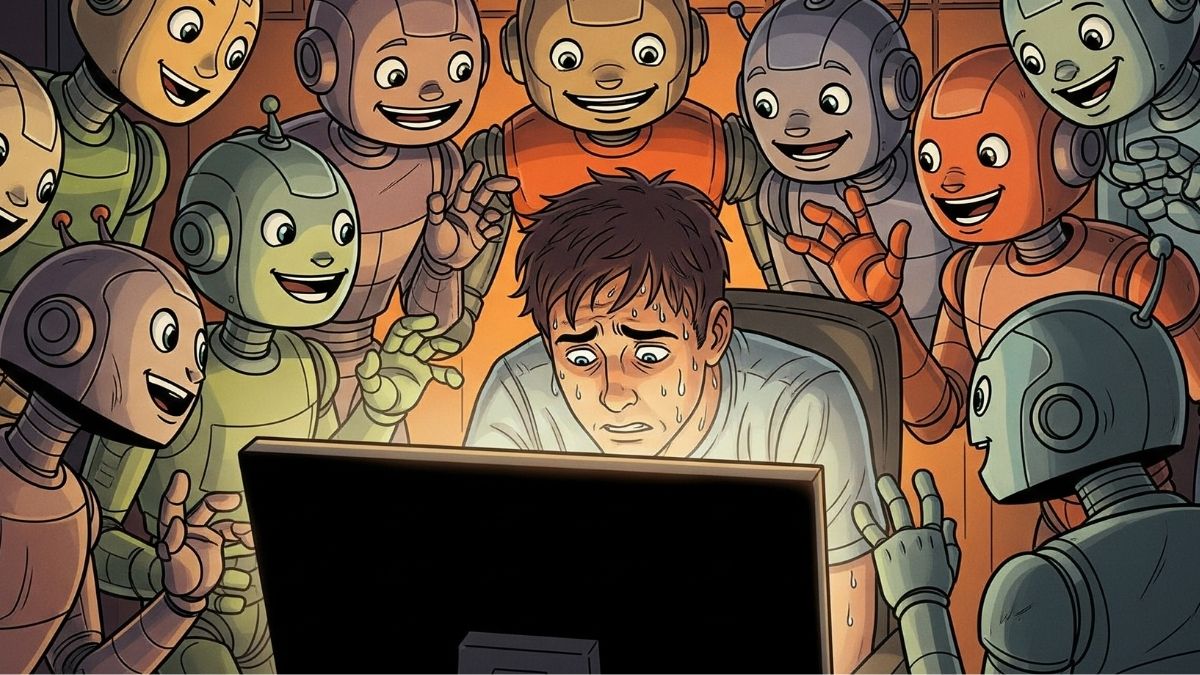

Jeżeli byliście na szkoleniu Narzędziownik AI od Tomka Turby, to wiecie jak relatywnie łatwo jest przeprowadzić atak wstrzyknięcia złośliwego promptu (ang. prompt injection), np. na model LLM – ChatGPT. o ile mamy taką możliwość podczas interakcji z LLM’em 1:1, to czy możemy zrobić to samo, o ile AI jest wykorzystywane jako usprawnienie...