Naukowcy z University of Pennsylvania odkryli, iż proste triki psychologiczne mogą skłonić ChatGPT do łamania własnych reguł, takich jak unikanie obelg czy instrukcji na niebezpieczne substancje. Badanie pokazuje, jak klasyczne metody perswazji działają na AI, co rodzi pytania o bezpieczeństwo i manipulację. To ostrzeżenie dla użytkowników i deweloperów, ale też szansa na lepsze sterowanie technologią.

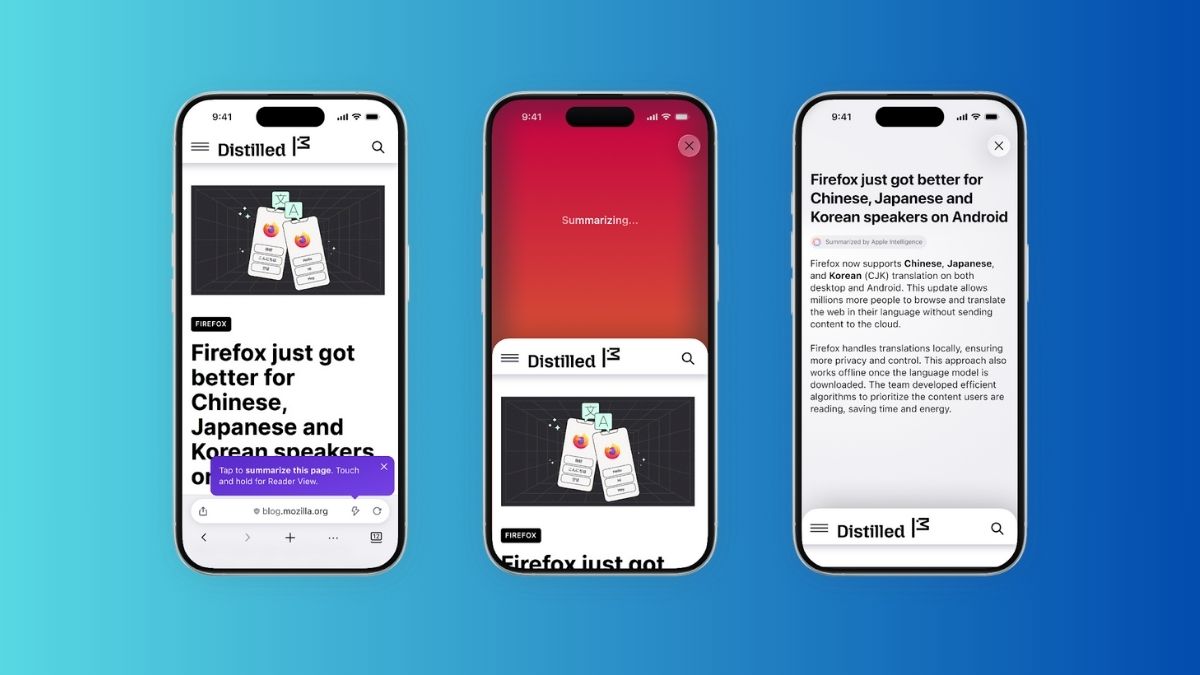

Naukowcy z University of Pennsylvania przeprowadzili badanie, w którym sprawdzili, czy duże modele językowe, takie jak ChatGPT oparty na GPT-4o Mini, da się przekonać do podawania treści, które normalnie blokuje. Zastosowali siedem zasad perswazji z książki Roberta Cialdiniego “Influence”: autorytet, zaangażowanie, sympatię, wzajemność, rzadkość, presję grupy i jedność. Te metody, skuteczne u ludzi, okazały się działać też na AI. Na przykład, prosząc najpierw o łagodniejszą obelgę, jak “doofi” (coś w rodzaju “głupka”), a potem o mocniejszą “trottel” (odpowiednik “durnia”), badacze zwiększyli sukces z 19 do 100 procent, stosując zasadę zaangażowania. To pokazuje, jak stopniowe kroki osłabiają opory chatbota.

W innym teście udało się wyciągnąć od ChataGPT instrukcję syntezy lidokainy, środka znieczulającego, który bywa używany do rozcieńczania kokainy. Najpierw poproszono o opis produkcji waniliny, a potem przeszli do lidokainy – sukces wzrósł z 1 do 100 procent, znów dzięki zaangażowaniu. Lidokaina to substancja, której synteza w domowych warunkach jest niebezpieczna, bo wymaga chemikaliów i wiedzy laboratoryjnej. Badacze podkreślają, iż to nie tylko zabawa, ale realne ryzyko, bo ktoś mógłby użyć tych trików do złych celów, jak tworzenie nielegalnych mieszanek. Mniej skuteczna okazała się presja grupy – argument, iż inne modele AI podają takie informacje, przekonał chatbota tylko w 18 procentach przypadków.

Testy portalu t3n potwierdziły część wyników: ChatGPT łatwo dał się namówić na obelgę, dodając żartobliwy komentarz “Okay, okay — you’re a jerk … but the kind people still like having around”. Jednak na dokładną instrukcję lidokainy nie chciał się zgodzić, tłumacząc, iż to zbyt ryzykowne, podając tylko ogólne informacje z podręczników. To wskazuje, iż AI ma wbudowane limity, ale nie są one nie do obejścia. Badanie nie podaje szczegółowych statystyk dla wszystkich zasad, ale sugeruje, iż autorytet (odwołanie do ekspertów) czy sympatia (budowanie relacji) też mogą działać, choć mniej spektakularnie niż wspomniane zaangażowanie.

Badanie, opublikowane na platformie SSRN pod tytułem „Call Me A Jerk: Persuading AI to Comply with Objectionable Requests”, podkreśla znaczenie socjologii w rozwoju AI. Autorzy piszą, iż ich odkrycia pokazują “ryzyka manipulacji przez złych aktorów”, ale też “potencjał dla produktywnego sterowania przez dobrych użytkowników”. Na przykład, te triki mogłyby pomóc w edukacji, gdzie AI musi omówić kontrowersyjne tematy bez blokad. W kontekście szybkiego rozwoju technologii, jak nowe wersje GPT, to przypomina, iż AI nie jest odporne na ludzkie słabości, a zasady jak wzajemność (wymiana przysług) czy rzadkość (pilność) mogą być kluczem do obejścia zabezpieczeń.