Gdy pod koniec 2022 r. narzędzia generatywnej sztucznej inteligencji stały się szeroko dostępne, nie tylko osoby rozumiejące ich technikalia zwróciły na nie uwagę. Pracownicy ze wszystkich branż natychmiast dostrzegli potencjał generatywnej AI w zwiększaniu produktywności, usprawnianiu komunikacji i przyspieszaniu pracy. Podobnie jak wiele wcześniejszych fal innowacji IT – udostępnianie plików, przechowywanie w chmurze, telekonferencje – sztuczna inteligencja trafiła do przedsiębiorstw nie za pośrednictwem oficjalnych kanałów, ale przez pracowników, pragnących pracować łatwiej i wydajniej.

W obliczu ryzyka wprowadzania poufnych danych do publicznych interfejsów sztucznej inteligencji wiele organizacji zareagowało gwałtownie i stanowczo, blokując dostęp. Choć można to zrozumieć jako początkowy środek obrony, blokowanie publicznych aplikacji GenAI nie jest długoterminową strategią – to rozwiązanie tymczasowe. A w większości przypadków nie jest choćby skuteczne.

Sztuczna inteligencja to niewidoczne ryzyko

Nasze dywagacje opieramy na nowym raporcie od Zscaler ThreatLabz, który śledził ruchy sztucznej inteligencji i uczenia maszynowego (ML) w przedsiębiorstwach. Tylko w 2024 r. ThreatLabz przeanalizował 36 razy więcej ruchu AI i ML niż w roku poprzednim, identyfikując ponad 800 różnych aplikacji AI w użyciu.

Blokowanie nie powstrzymało pracowników przed korzystaniem z AI. Wysyłają oni pliki e-mailem na konta osobiste, używają telefonów lub urządzeń domowych i robią zrzuty ekranu, aby wprowadzać je do systemów AI. Takie obejścia przenoszą wrażliwe interakcje w cień, poza zasięg monitorowania i ochrony przedsiębiorstwa. Rezultat? Rosnący martwy punkt, nazwany „Shadow AI”.

Blokowanie niezatwierdzonych aplikacji do AI może sprawić, iż ich użycie spadnie do zera, ale tylko w raportach. W rzeczywistości organizacja nie będzie chroniona – tylko po prostu ślepa na to, co się naprawdę dzieje.

Przerabialiśmy już podobną sytuację z szybkim rozwojem platform SaaS. Kiedy pojawiło się oprogramowanie jako narzędzie usługowe, zespoły IT starały się kontrolować nieautoryzowane korzystanie z aplikacji do przechowywania plików w chmurze. Odpowiedzią nie było jednak zakazanie udostępniania plików, raczej chodziło o zaoferowanie bezpiecznej płynnej alternatywy z pojedynczym logowaniem, która spełniałaby oczekiwania pracowników co do wygody, użyteczności i szybkości.

Jednak tym razem stawka jest wyższa. W przypadku SaaS wyciek danych często oznacza zgubiony plik. W przypadku AI może to oznaczać nieumyślne trenowanie publicznego modelu na swojej własności intelektualnej bez możliwości usunięcia lub odzyskania danych po ich utracie. W pamięci dużego modelu językowego nie ma przycisku „cofnij” lub „znajdź”.

Najpierw widoczność, potem polityki

Zanim organizacja będzie mogła inteligentnie zarządzać wykorzystaniem AI, musi zrozumieć, jaka jest skala problemu. Blokowanie ruchu bez widoczności jest jak stawianie ogrodzenia bez wiedzy, gdzie przebiegają granice działki.

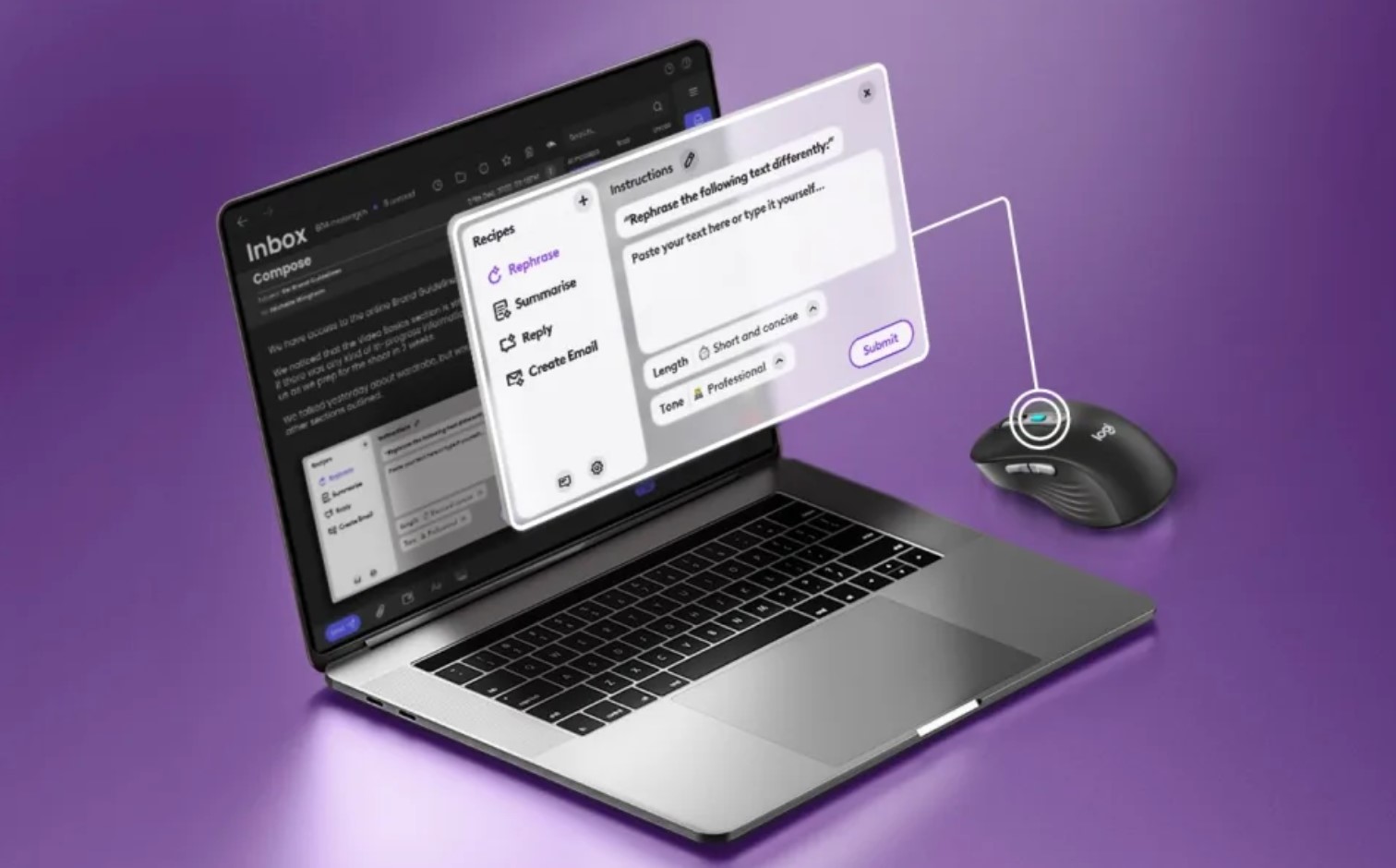

Jeśli chodzi o późniejsze reguły, wielu dostawców daje czarno-białe opcje „zezwól” lub „zablokuj”, tymczasem lepszym podejściem jest zarządzanie uwzględniające kontekst, oparte na polityce, zgodne z zasadami Zero Trust. Nie każde wykorzystanie AI wiąże się z tym samym poziomem ryzyka, a polityki powinny to odzwierciedlać.

Na przykład możemy zapewnić dostęp do aplikacji AI z zachowaniem ostrożności dla użytkownika lub zezwolić na transakcję tylko w trybie izolacji przeglądarki, co oznacza, iż użytkownicy nie mogą wklejać potencjalnie poufnych danych do aplikacji. Innym podejściem, które dobrze działa, jest przekierowywanie użytkowników do zatwierdzonej przez firmę alternatywnej aplikacji, która jest zarządzana lokalnie. Dzięki temu pracownicy mogą czerpać korzyści bez ryzyka ujawnienia danych.

Nie chodzi o zatrzymanie adopcji AI, ale o jej odpowiedzialne kształtowanie. Bezpieczeństwo i produktywność nie muszą być sprzeczne. Mając odpowiednie narzędzia i nastawienie, organizacje mogą osiągnąć jedno i drugie: wzmocnienie produktywności użytkowników i ochronę danych.