Jeszcze dwa lata temu deepfake był dla nas jedynie ciekawostką z YouTube’a – często niedopracowaną, z widocznymi błędami w okolicach ust czy nienaturalnym mruganiem. Jednak w styczniu 2026 roku wkraczamy w erę Deepfake 2.0. To moment, w którym technologia generatywnej sztucznej inteligencji przestała być narzędziem filmowców, a stała się bronią w rękach cyberprzestępców, działającą w czasie rzeczywistym.

Dziś nie mówimy już o statycznych przeróbkach zdjęć. Mamy do czynienia z tzw. Agentic AI, która potrafi w ułamku sekundy nałożyć cyfrowy filtr na dowolną osobę podczas rozmowy na żywo, kopiując jej gesty, emocje, a choćby specyficzne spojrzenie. Granica między prawdą a cyfrową symulacją niemal całkowicie się zatarła, a my – jako użytkownicy nowoczesnych technologii – musimy nauczyć się patrzeć na nasze ekrany z zupełnie nową dawką sceptycyzmu.

W tym poradniku przeprowadzimy was przez mroczne zakamarki technologii 2.0. Pokażemy, jakie triki stosują oszuści, by nas zmanipulować, i co najważniejsze – zdradzimy proste, techniczne sposoby na to, jak „rozbić” maskę AI podczas rozmowy, by nie stać się ofiarą najnowocześniejszego oszustwa naszych czasów.

Warto przeczytać: Jak poprawić bezpieczeństwo domowej sieci Wi-Fi? Podpowiadamy

Jak rozpoznać oszustwo AI?

Mimo iż technologia, którą umownie nazwijmy Deepfake 2.0 poczyniła ogromne postępy, algorytmy wciąż mają swoje słabe punkty, które wynikają z potrzebnej im ogromnej mocy obliczeniowej niezbędnej do renderowania obrazu na żywo, a nie zawsze ją otrzymują. Aby nie dać się zmanipulować, musimy stać się aktywnymi obserwatorami. Oto najskuteczniejsze metody weryfikacji.

Test „profilu”, czyli boczny skręt głowy. To w tej chwili nasza najpotężniejsza broń. Większość modeli AI w tym roku doskonale poradzi sobie z twarzą zwróconą bezpośrednio do kamery, ale gubi się przy gwałtownym obrocie głowy o 90 stopni. jeżeli poprosimy rozmówcę, by spojrzał w bok, możemy dostrzec tzw. artefakty – nos może na chwilę „odkleić się” od twarzy, a krawędź policzka może stać się nienaturalnie rozmyta.

Interakcja fizyczna z twarzą. jeżeli skłonimy osobę po drugiej stronie, aby pomachała dłonią przed oczami lub powoli przesunęła palcem po ustach. Dla algorytmu renderującego cyfrową maskę w czasie rzeczywistym tzw. okluzja (zasłonięcie obiektu innym obiektem) jest koszmarem. Zobaczymy wtedy charakterystyczne „drganie” pikseli lub chwilowe przenikanie palców przez skórę twarzy.

Analiza oświetlenia i cieni. Przyjrzyjmy się dokładnie, skąd pada światło. jeżeli nasz rozmówca twierdzi, iż jest w nasłonecznionym biurze, a cienie pod jego nosem lub oczami wydają się być generowane przez punktowe źródło światła z innej strony, mamy niemal pewność, iż to nałożone tło i wygenerowana postać. Modele AI często nie nadążają z synchronizacją oświetlenia dynamicznego.

Nienaturalna spójność emocjonalna. W nowych deepfake’ach algorytmy świetnie naśladują uśmiech, ale rzadko radzą sobie z mikroekspresjami. Zwróćmy uwagę czy oczy „uśmiechają się” razem z ustami. jeżeli twarz wydaje się zbyt gładka, a mruganie jest zbyt rzadkie lub nienaturalnie regularne, nasza czujność powinna wzrosnąć do maksimum.

Pytania kontrolne. Poza aspektami wizualnymi, zagrajmy wiedzą, której AI nie ma. Zadajmy pytanie o coś, co wydarzyło się wczoraj, a nie było publikowane w sieci. Zapytajmy o wspólny żart lub imię psa, którego nie ma na zdjęciach profilowych. jeżeli rozmówca unika odpowiedzi lub zaczyna mówić ogólnikami, prawdopodobnie mamy do czynienia z botem lub oszustem korzystającym z bazy danych o nas.

Narzędzia do walki z materiałami generowanymi przez AI

Przechodząc do kwestii konkretnych rozwiązań obronnych, musimy zdać sobie sprawę, iż w 2026 roku walka z oszustwami w sieci nie będzie się opierać wyłącznie na naszej intuicji, ale przede wszystkim na zaawansowanym oprogramowaniu weryfikacyjnym. Jednym z najważniejszych narzędzi w naszym arsenale stają się detektory AI w czasie rzeczywistym, które działają jako warstwa ochronna podczas przeglądania sieci lub prowadzenia wideokonferencji. Takie programy analizują strukturę pikseli pod kątem tzw. szumu cyfrowego, który jest niemal niewidoczny dla ludzkiego oka, ale stanowi charakterystyczny podpis zostawiany przez generatory obrazu. Korzystając z takich rozwiązań, możemy otrzymać natychmiastowe powiadomienie, jeżeli system wykryje, iż strumień wideo przesyłany przez naszego rozmówcę wykazuje cechy syntetyczności.

Równie istotna staje się weryfikacja dzięki metadanych i standardów takich jak C2PA, który powoli staje się powszechnym certyfikatem autentyczności treści. Jako świadomi użytkownicy powinniśmy szukać w naszych aplikacjach do komunikacji ikon „cyfrowego podpisu”. Jest to technologia, która pozwala sprawdzić pochodzenie materiału od momentu jego przechwycenia przez obiektyw aparatu aż po wyświetlenie na naszym ekranie. jeżeli otrzymujemy nagranie, które nie posiada zweryfikowanego łańcucha pochodzenia, systemy bezpieczeństwa w naszych telefonach coraz częściej będą nas ostrzegać o potencjalnej manipulacji, co stanowi kluczową barierę przed dezinformacją.

Nie możemy zapominać o warstwie dźwiękowej, ponieważ to właśnie klonowanie głosu stało się najczęstszym punktem wyjścia dla ataków typu Deepfake 2.0. Współczesne narzędzia do analizy akustycznej potrafią wykryć brak naturalnych artefaktów oddechowych lub zbyt idealną częstotliwość fal dźwiękowych, które są typowe dla syntezatorów mowy. Warto korzystać z dedykowanych aplikacji filtrujących połączenia głosowe, które w tle porównują próbkę głosu rozmówcy z bazą znanych wzorców AI. Takie rozwiązania staną się standardowym elementem nowoczesnych pakietów antywirusowych, przekształcając klasyczną ochronę przed złośliwym oprogramowaniem w kompleksowe centra ochrony tożsamości cyfrowej.

Ostatnim ogniwem tej technologicznej tarczy są rozszerzenia przeglądarkowe nowej generacji, które będą potrafiły weryfikować treści publikowane w mediach społecznościowych jeszcze zanim w ogóle w nie klikniemy. Będą one funkcjonować w oparciu o globalne bazy danych „odcisków cyfrowych” znanych oszustw, dzięki czemu unikniemy kontaktu z zmanipulowanym wideo, które krąży w sieci jako wiral.

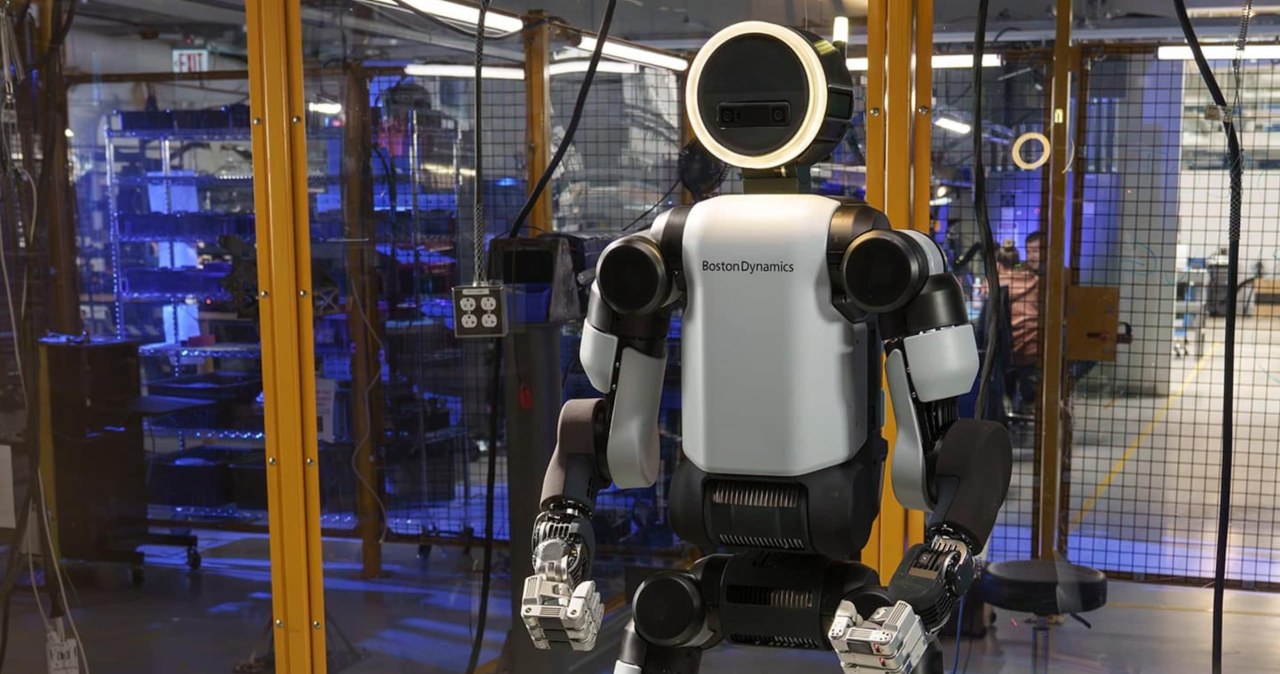

AI jest dziś w stanie skopiować nie tylko wygląd, ale mimikę, gesty a choćby głos. Fot. HotGear.

Jak jeszcze możemy się bronić?

Niezależnie od tego, jak bardzo zaawansowane stają się systemy detekcji, musimy pamiętać, iż w starciu z technologią Deepfake 2.0 najskuteczniejszą linią obrony pozostaje czynnik ludzki i proste, analogowe rozwiązania. Jedną z najbardziej rekomendowanych metod jest wprowadzenie w kręgu rodzinnym oraz wśród najbliższych współpracowników unikalnego hasła bezpieczeństwa. Jest to ustalone wcześniej słowo, fraza lub krótkie pytanie o fakt z naszej wspólnej przeszłości, którego nie da się znaleźć w mediach społecznościowych, a które pozwala w sekundę zweryfikować tożsamość rozmówcy.

W dobie idealnych kopii cyfrowych takie rozwiązanie staje się naszym prywatnym, niepodrabialnym certyfikatem autentyczności, którego żaden algorytm nie jest w stanie przewidzieć ani wygenerować bez dostępu do naszych prywatnych wspomnień.

Wprowadzenie takiego hasła powinno stać się standardem higieny cyfrowej w każdym domu, podobnie jak dbanie o silne hasła do bankowości czy dwuskładnikowe uwierzytelnianie. Ważne jest, abyśmy ustalili je podczas bezpośredniego spotkania, unikając przesyłania go komunikatami tekstowymi, które mogłyby zostać przejęte przez złośliwe oprogramowanie.

W sytuacji, gdy odbieramy podejrzany telefon od „wnuczka” czy „partnera” z prośbą o pilną pomoc finansową, prośba o podanie hasła bezpieczeństwa natychmiast ucina pole manewru oszustowi. jeżeli nasz rozmówca zacznie unikać odpowiedzi, denerwować się lub twierdzić, iż zapomniał hasła przez stres, powinna zapalić się nam w głowie czerwona lampka, skłaniająca do natychmiastowego rozłączenia się i próby kontaktu z tą osobą innym kanałem.

Pamiętajmy również, iż takie hasło warto okresowo odświeżać, zwłaszcza jeżeli podejrzewamy, iż nasze dane mogły wyciec do sieci. Warto uczyć tego procederu szczególnie osoby starsze, które są najbardziej narażone na manipulacje socjotechniczne wykorzystujące technologię wideo. Edukacja naszych bliskich w zakresie ograniczania zaufania do tego, co widzą na ekranie, w połączeniu z taką prostą „bezpieczną kotwicą”, tworzy barierę, której nie pokona choćby najpotężniejsza karta graficzna generująca obraz AI.

Co zrobić, jeżeli zorientujemy się, iż po drugiej stronie mamy oszustwo?

Jeśli mimo naszej ostrożności poczujemy, iż sytuacja wymyka się spod kontroli lub padniemy ofiarą manipulacji, musimy działać gwałtownie i według sprawdzonego schematu.

- Natychmiast zrywamy połączenie – jeżeli tylko nabierzemy podejrzeń, nie kontynuujmy rozmowy. Każda sekunda dostarcza oszustom więcej próbek naszego głosu i mimiki, które mogą wykorzystać w przyszłości.

- Zweryfikujmy sytuację innym kanałem – zadzwońmy do danej osoby na jej tradycyjny numer telefonu lub skontaktujmy się przez inny komunikator, którego nie używaliśmy przed chwilą.

- Zabezpieczmy dowody – jeżeli to możliwe, zróbmy zrzut ekranu lub nagrajmy fragment rozmowy. Takie materiały będą bezcenne dla organów ścigania oraz dla dostawców usług w celu blokowania kont oszustów.

- Poinformujmy bank i zablokujmy dostęp do kont – o ile w trakcie rozmowy podaliśmy jakiekolwiek dane finansowe lub kody autoryzacyjne, każda minuta ma znaczenie dla ochrony naszych oszczędności.

- Zgłośmy incydent na platformie – skorzystajmy z opcji „zgłoś oszustwo” w aplikacji (np. WhatsApp, Messenger), aby algorytmy bezpieczeństwa mogły szybciej oznaczyć profil przestępcy.

- Ostrzeżmy wspólnych znajomych – oszuści często działają seriami, atakując osoby z tej samej listy kontaktów. Krótka informacja na grupie rodzinnej może uratować kogoś innego przed błędem.

Podsumowanie

Rok 2026 roku stawia przed nami wyzwania, o których jeszcze kilka lat temu czytaliśmy wyłącznie w powieściach science-fiction. Technologia AI sprawiła, iż obraz i dźwięk przestały być niepodważalnym dowodem prawdy. Musimy jednak pamiętać, iż choć narzędzia oszustów stają się coraz doskonalsze, to nasza czujność, krytyczne myślenie i proste zasady ograniczonego zaufania pozostają najskuteczniejszą tarczą. Wiedza o tym, jak działają takie mechanizmy, to pierwszy i najważniejszy krok do pełnego bezpieczeństwa w cyfrowym świecie. Bądźmy ciekawi nowych technologii, ale zawsze trzymajmy rękę na pulsie.

Tomasz Sławiński