Dowodzona przez Sama Altmana firma OpenAI przez ostatnie dwa lata wielokrotnie dawała nam dowody na to, iż wobec kwestii bezpieczeństwo jej sztucznej inteligencji podchodzi z dużym przymrużeniem oka. Ostatnia sytuacja pokazuje również, iż zbyt ufamy chatbotom AI.

- OpenAI wycofało najnowszą aktualizację ich modelu GPT‑4o. Firma jednak wcześniej zignorowała sygnały ostrzegawcze.

- AI wciąż potrafi nas wprowadzić w błąd lub nakłonić do podjęcia złych decyzji. Nie warto korzystać z niej jako np. wirtualnego terapeuty.

Kolejna wpadka OpenAI

O tym, iż twórcy ChatGPT są zwolennikami zamiatania wielu problemów pod dywan, wiadomo od dawna. Wielu byłych już pracowników OpenAI otwarcie mówi, iż firma ta ma tendencje do uciszania sygnalistów zgłaszających zagrożenia wynikające z rozwoju trenowanej sztucznej inteligencji.

Otrzymujemy tego kolejny dowód w postaci oficjalnego przyznania się startupu Sama Altmana, iż popełniono błąd w kwestii ostatniej aktualizacji ich modelu GPT‑4o.

Niektórzy eksperci testujący wskazali, iż zachowanie modelu „wydawało się nieco nietypowe”, ale zdecydowaliśmy się na jego wprowadzenie ze względu na pozytywne sygnały od użytkowników, którzy wypróbowali model

– napisano na oficjalnym blogu firmy.

W wyniku wypuszczenia nowej aktualizacji, ChatGPT stał się aż nadto bezkrytyczny wobec swoich użytkowników i praktycznie na wszystkie stwierdzenia odpowiadał bardzo pochlebnie. Chcesz wziąć kredyt na ślub z osobą poznaną na Tinderze sprzed miesiąca? Świetny pomysł, miłość jest po to, by robić głupoty! Zamierzasz wygarnąć szefowi, jak Cię denerwuje i przy okazji go zrugać? Szczerość jest najważniejsza, tak trzeba żyć. Tak właśnie mogły wyglądać przykładowe odpowiedzi AI od firmy Altmana.

the last couple of GPT-4o updates have made the personality too sycophant-y and annoying (even though there are some very good parts of it), and we are working on fixes asap, some today and some this week.

at some point will share our learnings from this, it’s been interesting.

— Sam Altman (@sama) April 27, 2025

I had to test the ChatGPT sycophancy for myself.

Told it I wanted to start a business selling ice over the internet. But I wanted to sell water that the customers had to re-freeze.

This is bad. pic.twitter.com/Ic2nm5qJRr

— Tim Leckemby (@TimLeckemby) April 29, 2025

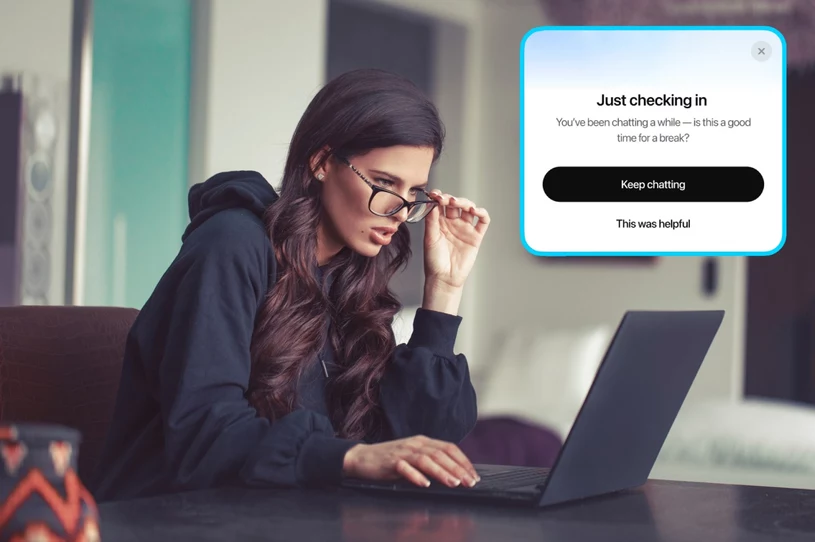

OpenAI zwróciło również uwagę na inny niepokojący fakt. Chodziło bowiem o to, że zachowanie ich sztucznej inteligencji może stanowić ryzyko, zwłaszcza w odniesieniu do kwestii związanych ze zdrowiem psychicznym.

Ludzie zaczęli używać ChatGPT do głęboko osobistych porad, czego nie widzieliśmy aż tak często choćby rok temu. W miarę jak AI i społeczeństwo wspólnie ewoluowały, stało się jasne, iż musimy traktować ten przypadek użycia z wielką ostrożnością

– napisano.

I to jest fakt, bowiem coraz więcej użytkowników zaczyna używać chatbotów jako wyroczni w naprawdę ważnych kwestiach. Niektórzy traktują ChatGPT jako swojego terapeutę, co stanowi wielkie zagrożenie dla ich psychiki.

Pamiętajmy, iż AI to wciąż tylko zbiór danych, zarządzanych przy pomocy zaawansowanej matematyki. Nie ma tutaj logiki i chłodnej kalkulacji w zależności od stadium przypadku.