Meta AI – poważna luka prywatności: dostęp do prywatnych wiadomości i odpowiedzi użytkowników

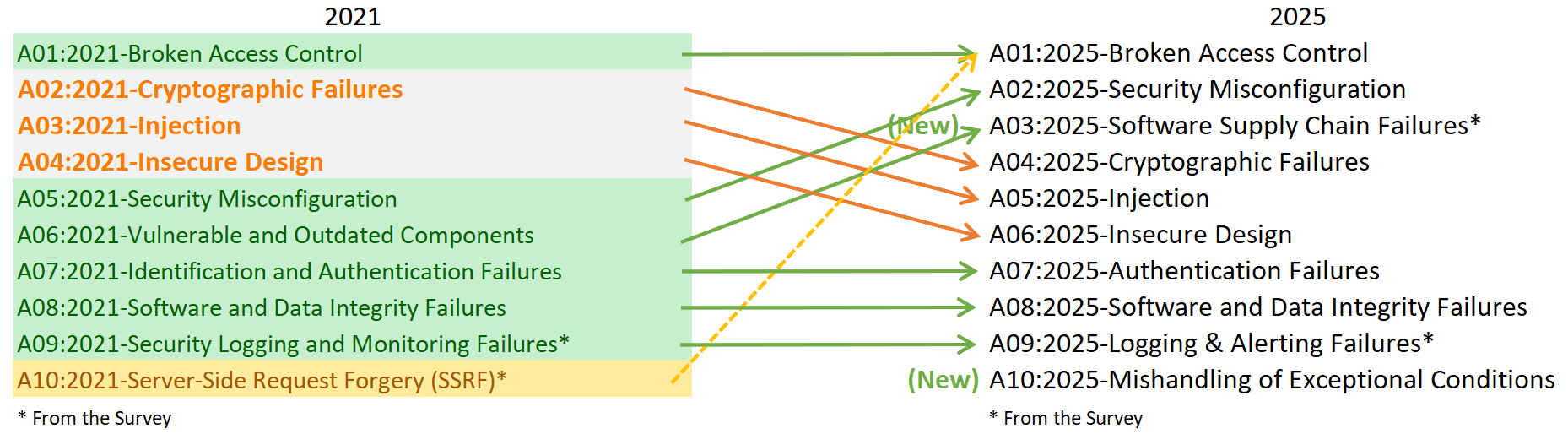

W styczniu 2025 roku Meta załatała poważną lukę w swoim systemie chatbotów Meta AI, która umożliwiała osobom trzecim dostęp do prywatnych „prompts” (zadań) i wygenerowanych przez AI odpowiedzi użytkowników. Luka została zgłoszona 26 grudnia 2024 roku przez badacza Sandeepa Hodkasię z firmy AppSecure, który za swoją pracę otrzymał 10 000 USD w ramach bug bounty. Firma wdrożyła naprawę 24 stycznia 2025, nie stwierdzając jednocześnie żadnych śladów faktycznego wycieku lub nadużyć.

Meta AI przypisywała każdej edycji prompta unikalny numer identyfikacyjny. Pracując nad edytowanym promptem, Hodkasia zauważył, iż można modyfikować ten identyfikator i uzyskać dostęp do promptów i odpowiedzi innych użytkowników. System Meta’a nie weryfikował, czy tego typu żądanie pochodzi od właściciela danej konwersacji – magnesem była łatwość zgadywania kolejnych numerów identyfikacyjnych.

🛡 Jakie były konsekwencje?

Chociaż Meta nie znalazła dowodów na realne wykorzystanie luki, incydent stanowi poważne ostrzeżenie. Niechronione prompt IDs mogły być użyte do masowego pozyskiwania danych osobowych, co – w rękach złośliwych aktorów – mogłoby służyć phishingowi lub szantażowi.

🌐 Dodatkowy problem: udostępnianie treści publicznie

Osobno, w czerwcu 2025 okazało się, iż wiele użytkowników przypadkowo publikowało prywatne rozmowy ze swoją Meta AI na publicznym „Discover feed”, sądząc, iż są one przezroczyste. Okazało się, iż interfejs zachęca do udostępniania, a proces jest nieintuicyjny – choćby tematykę medyczną, prawną czy osobiste wyznania, bez świadomości użytkowników uczynił publicznymi.

Meta twierdziła, iż chaty są prywatne, dopóki użytkownik nie przejdzie przez wieloetapowy proces udostępnienia – jednak doświadczenia pokazują, iż wiele osób błędnie interpretowało domyślne ustawienia.

✅ Co powinieneś wiedzieć i zrobić?

| Domyślna widoczność promptów | Podejrzenia, iż niektóre prywatne czaty mogą przypadkowo trafić do Discover |

| Ustawienia widoczności w aplikacji | W aplikacji Meta AI wybrać: Data & Privacy → Manage your information → „Make all prompts visible only to you” |

| Unikać przycisku „Share” | Tylko w pełni świadomie, z pełną kontrolą treści |

| Korzystanie bez logowania | Wyloguj się z platform Meta (Facebook, Instagram, WhatsApp), o ile używasz Meta AI na tych platformach |

| Zachowanie ostrożności z danymi | Nie wprowadzać w AI informacji osobistych, medycznych, prawnych |

📝 Podsumowanie

Luka w Meta AI pozwalała uzyskać dostęp do cudzych promptów i wygenerowanych odpowiedzi w okresie 26 grudnia 2024 – 24 stycznia 2025, została naprawiona bez śladów wykorzystania MalwarebytesTom’s Guide.

Osobno, wiele prywatnych rozmów trafiło publicznie do „Discover feed” z powodu niejasnego UX – choćby wtedy, gdy użytkownicy ich nie chcieli publikować Onlineportal von IT Management+13Malwarebytes+13eWEEK+13.

Niezależnie od tych incydentów – ważne jest, aby dokładnie rozumieć ustawienia prywatności, unikać nieświadomego udostępniania, oraz nie traktować konwersacji z AI jako poufnych, choćby jeżeli platforma twierdzi inaczej.

🧩 Dlaczego to ważne?

W miarę jak korzystamy z AI coraz częściej—włączając w to prywatne, wrażliwe treści—każda niedopatrzona luka może doprowadzić do poważnych wycieków danych.

Meta AI to przykład, iż choćby użytkownicy renomowanych firm mogą być narażeni na ryzyko wyciągnięcia prywatnych danych, nie tylko przez świadome działania, ale i przez błędy techniczne lub UX.

Warto zawsze podchodzić do rozwiązań AI z ostrożnością, wiedząc, iż „chat” nie musi oznaczać „bezpieczne”.